(머신러닝) 학습된 모델을 평가하는 척도는 어떤 것이 있을까?

728x90

반응형

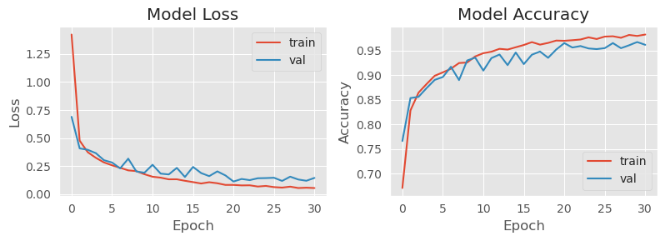

학습된 모델들을 평가하는 척도에 대해서 알아보자

(Model metrics)

1. 모델 평가 척도는 왜 필요할까?

- 모델이 "잘" 학습되었는가를 확인할 수 있는 평가 수준이 필요

→ 현업에서는 공통적으로 공감할 수 있는 지표가 필요하다.

모델링을 하는 사람과 현업을 하는 사람들의 언어는 전혀 다르기 때문에 모두가 공통적으로 공감할 수 있는 지표가 필요하다.

2. 많이 쓰이는 척도

모델을 평가하는 척도에는 일반적으로 많이 쓰이는 것과 잘 쓰이지는 않지만, 알아두면 언젠가 쓰일 수 있는 척도들이 있다.

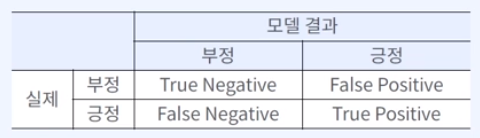

# 일반적으로 많이 사용되는 모델 평가 척도 (분류)

- Accuracy (정확도) : 분류의 전체적인 정확도를 확인할 수 있는 지표

- Recall (재현율) : 분류하고자 하는 클래스를 분류하였는지를 측정하는 지표 (중요)

→ ex) 병원에 다시 오게 될 사람에 대한 모델이라면, 온 사람들이 모두 recall.

- Precision : 모델이 분류한 클래스가 제대로 분류하였는지를 측정하는 지표 (중요)

→ ex) 맞춰야 하는 정답이 총 100개인데, 그 중 제대로 맞춘 것은?

- F1 : Recall과 Precision의 조화 평균

→ MAE의 값이 커지는 경우, 루트를 씌워서 값을 작게 만들어서 분석

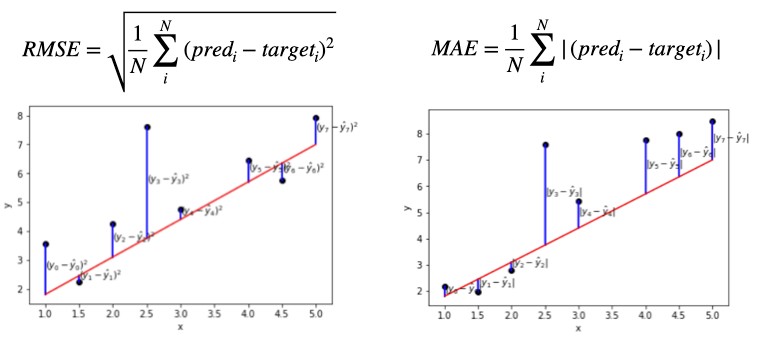

# 일반적으로 많이 사용되는 모델 평가 척도 (회귀)

- MAE (Mean Average Error) : 실제 값과 예측 값의 차이 평균

→ ex) 금액을 맞춰야 하는 상황에서 실제로 10,000인데, 예측값이 11,000원이면? 에러 측정하여 평균

→ 해석하기가 어려울 수 있다. 해석을 위해 MAPE와 함께 표기될 수 있다.

- MAPE(Mean Average Percentile Error) : 실제 값과 예측 값의 비율 차이의 평균

→ 비율적(%)으로 얼마나 에러가 발생했는지 확인

- MSE (Mean Squared Error) : 실제 값과 예측 값의 차이를 제곱하고 평균

→ 작은 에러는 더 작게 만들어주고, 큰 에러는 더 크게 만든다.

- RMSE (Root Mean Squared Error) : MSE에 제곱근

3. 특수한 상황에서 쓰이는 척도

명확하게 특정 분야에만 사용되어서 다른 부문에서는 못 쓰는 곳인 경우는?

# 클래스가 명확히 나눠지지 않고 순위로만 평가하는 경우(추천)

- Precision@k : 예측한 결과의 상위 k개와 실제 결과의 상위 k개의 매칭 정도

- Recall@k : 예측한 결과 k개 중 실제 결과에서 나왔어야 하는 정도

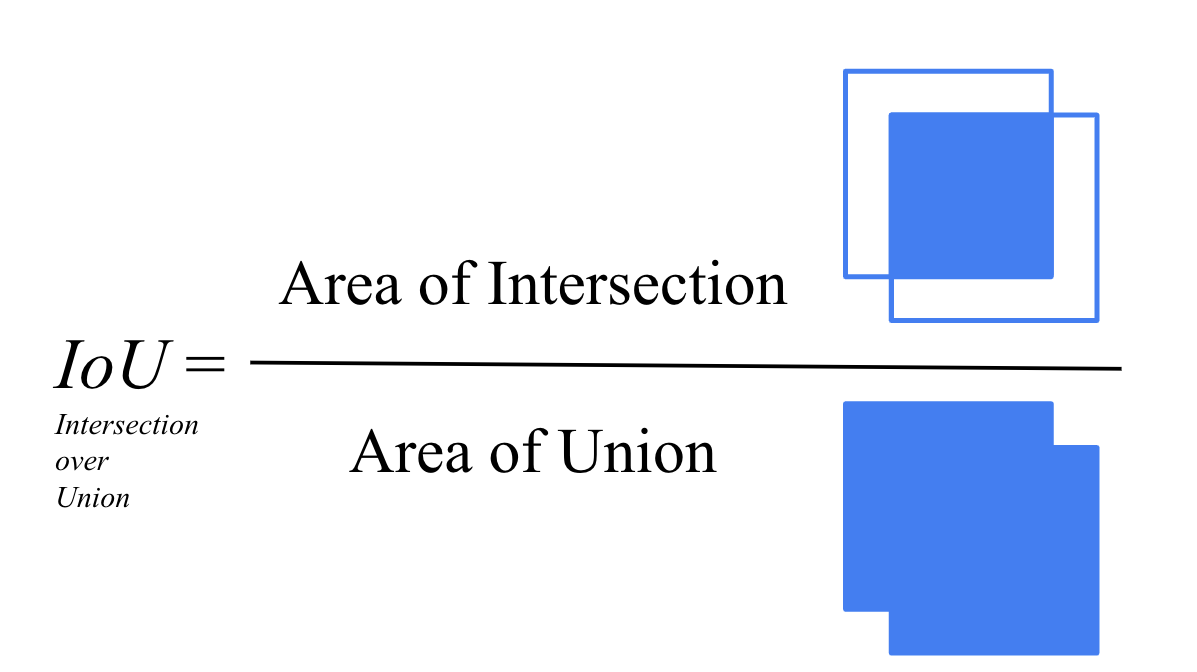

# 겹치는 정도를 측정하기 위해 사용하는 척도 (이미지)

- IoU (Intersection of Union)

# 데이터 간의 거리를 측정하기 위해 사용하는 척도

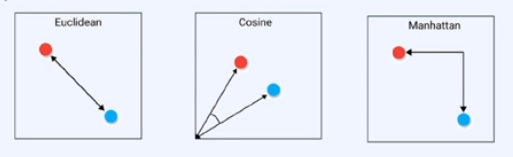

- Distance(Euclidean, Cosine, Manhattan)

→ Euclidean(직선거리), Cosine(2개의 거리를 각도로)

학습 참고 : 50개 프로젝트로 완벽하게 끝내는 머신러닝 SIGNATURE (패스트캠퍼스)

'Machine Learning > 데이터 분석 이론과 기초' 카테고리의 다른 글

| (머신러닝) Overfitting은 꼭 해결해야되는 문제일까? (0) | 2024.03.01 |

|---|---|

| (머신러닝) 쉽게 이해하는 Cross Validation. 기법과 원리는? (0) | 2024.03.01 |

| (머신러닝) 데이터를 'Train, Validation, Test'로 나누는 이유는? (2) | 2024.02.28 |

| (머신러닝) Clustering이란? K-means 알고리즘 원리 간단 정리! (2) | 2024.02.27 |

| (머신러닝) Classification(분류)에 대해 정확히 알고 가자 (1) | 2024.02.27 |

댓글